I progressi nell'intelligenza artificiale (IA) sono strettamente legati all'evoluzione dell'hardware. La necessità di una potenza di calcolo sempre maggiore, richiesta dai modelli di IA, ha spinto l'industria a superare i limiti dei processori tradizionali, inaugurando una nuova era dominata dalle unità di elaborazione grafica (GPU) e da una nuova generazione di chip specializzati per l'IA, come le Tensor Processing Unit (TPU) di Google.

Prima di addentrarci nell'hardware, è fondamentale fare un cenno al concetto di “tensore”. In un contesto di machine learning e deep learning, i tensori sono i mattoni fondamentali con cui i dati vengono organizzati e manipolati. Un tensore è una struttura di dati multidimensionale che generalizza concetti più familiari come scalari (numeri singoli), vettori (array unidimensionali) e matrici (tabelle bidimensionali).

Queste strutture sono fondamentali perché consentono di rappresentare e lavorare con dati complessi, come immagini, audio e testo. Ad esempio, un'immagine a colori con una risoluzione di 64x64 pixel può essere rappresentata come un tensore 3D con forma (3, 64, 64), dove i tre canali (rosso, verde e blu) rappresentano ciascuno una dimensione.

La potenza dei tensori risiede nella loro capacità di sfruttare l'accelerazione hardware. Sono infatti progettati per operazioni complesse che vengono eseguite in modo massicciamente parallelo su unità di calcolo ad alte prestazioni, come le GPU.

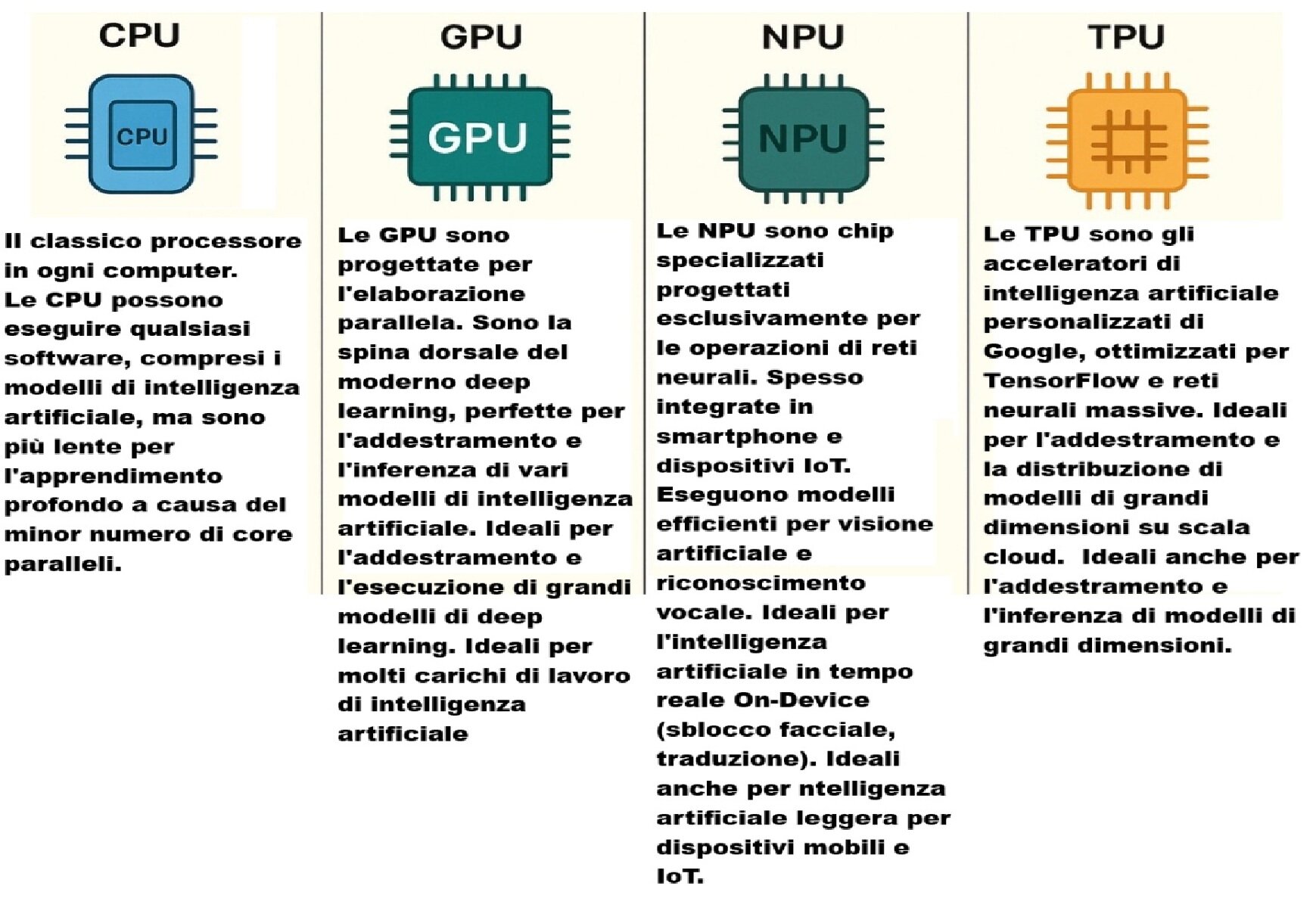

Per anni, le GPU sono state la forza motrice dei progressi nell'IA. Nati per l'elaborazione di grafica 3D, questi processori (ad esempio quelli di NVIDIA) hanno un'architettura intrinsecamente parallela, perfetta per il calcolo richiesto dall'addestramento e dall'inferenza dei modelli di machine learning.

Nei data center delle grandi aziende, come Google, Facebook, Microsoft e Amazon, tantissime GPU sono collegate in parallelo in quelli che vengono definiti "sistemi di GPU computing". Tuttavia, con l'aumento della complessità dei modelli di IA, la loro potenza e, soprattutto, il loro elevato consumo energetico le stanno rendendo meno efficienti per gli ambiti più avanzati. Questo limite spinge la ricerca verso hardware più specifico.

Google è stata tra le prime a comprendere la necessità di un hardware dedicato, creando le Tensor Processing Unit (TPU), un circuito integrato specifico per l'applicazione (ASIC), progettato per accelerare i carichi di lavoro del machine learning e dell'IA. Le TPU rappresentano un salto di qualità significativo, soprattutto per le operazioni sui tensori: Secondo dati presentati da Google, le TPU offrono prestazioni da 15 a 30 volte superiori rispetto alle GPU più potenti e raggiungono un'efficienza energetica da 30 a 80 volte superiore rispetto a CPU e GPU, un fattore cruciale per i data center che gestiscono miliardi di richieste. Parlando di tensori, è importante sottolineare la differenza tra un tensore e un modello di IA: il tensore è la struttura che memorizza i dati in forma multidimensionale (come testo o immagini) e anche i parametri di un modello AI; il modello è l'algoritmo (come una rete neurale) che elabora questi tensori per apprendere e per fare previsioni. Un modello si "allena" usando i tensori: durante l'addestramento, il modello elabora i tensori dei dati di input per imparare a mappare questi input agli output desiderati. Una volta addestrato, il modello può ricevere tensori di nuovi dati per fare inferenza, ovvero previsioni o decisioni su nuovi dati.

Dal lato consumer le novità sono gli AI PC, che sfruttano l'intelligenza artificiale in modo nativo, cioè con hardware e software ottimizzati per eseguire compiti di AI direttamente sul dispositivo e senza ricorrere al cloud (riconoscimento vocale, visione artificiale, traduzione in tempo reale, ecc.). Questi PC dispongono, oltre alle tradizionali CPU e GPU, anche di un’unità di calcolo pensata appositamente per le funzioni AI: la NPU, acronimo di Neural Processing Unit. In sostanza, la NPU è un processore progettato specificamente per l’esecuzione di algoritmi di machine learning (ML) e deep learning (DL), dotato di istruzioni specifiche per gestire i calcoli matematici complessi delle reti neurali. La sua forza risiede nel calcolo in parallelo di grandi quantità di dati, richiesto da applicazioni come il riconoscimento delle immagini, il natural language processing (NLP) e altre funzioni AI. L'obiettivo primario delle NPU è quello di sgravare CPU e GPU da una parte del lavoro di calcolo per le funzioni AI, consentendo al sistema di risultare più performante e consumare meno energia. Sui sistemi consumer, le NPU sono solitamente integrate nella CPU principale, mentre nei data center possono essere chip dedicati e fisicamente distinti. L'evoluzione delle architetture hardware ha portato all'integrazione di tutti i sistemi di calcolo su un unico die: il SoC (System on a Chip). I SoC, già diffusissimi in smartphone e tablet, integrano vari processori come CPU, GPU e NPU, oltre alla memoria RAM e SSD, riducendo al minimo le latenze di comunicazione.

.png)